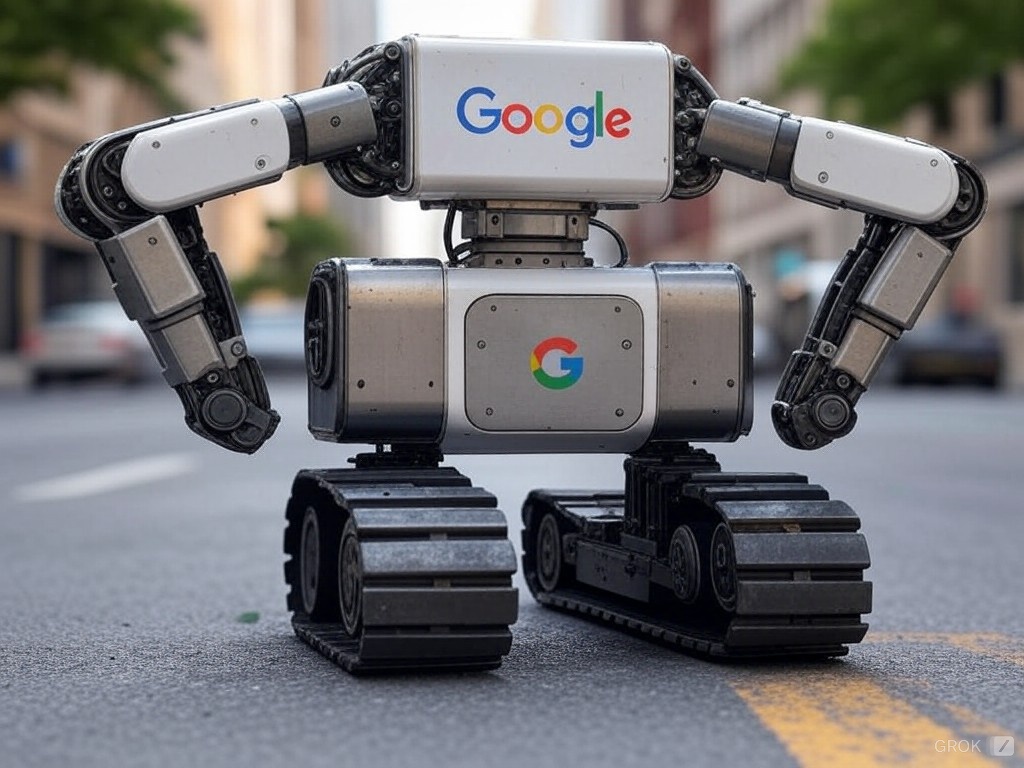

ホームページを作成してみたり、またはその関係に携わると必ずと言って良いほど耳にするのが「SEO対策」という単語になるかと思います。さらに「SEO対策」の事を深掘りしていくと、今回説明する「googleクローラー」という単語になる。

今回は、この「googleクローラー」と呼ばれているものが何なのか? その説明を初心者の方でも分かる様に説明してクローラーの正体を確認していきます。

1. googleクローラーとは

Googleクローラーは、Google検索エンジンがウェブの情報を収集するために使用する自動化プログラムです。これは「クローラー」や「スパイダー」とも呼ばれ、インターネット上のウェブページを巡回し、コンテンツを分析して検索結果に表示するためのデータベースにインデックスを作成します。クローラーは新しいウェブサイトを発見し、既存のサイトが更新されているかをチェックすることで、Googleの検索結果が常に最新で関連性の高いものになるようにします。

クローラーはリンクをたどることで新たなページを見つけ、テキスト、画像、動画などのコンテンツを評価します。しかし、全てのページを即座にクロールするわけではなく、サイトの人気度や更新頻度、リンクの構造などに基づいて訪問優先度が決まります。

サイト運営者は、robots.txtファイルや特定のメタタグ(noindexやnofollow)を使って、クローラーがどのページをクロールするかを制御することが可能です。これにより、プライバシーやリソース管理を考慮したウェブサイト運営が可能になります。

2. クローラーの役割

Googleクローラー(またはGooglebot)は、インターネット上のウェブページを訪れ、その内容を読み取ることでGoogleの検索インデックスを更新します。これにより、ユーザーが検索した際に最新かつ関連性の高い情報を提供することが可能になります。

ウェブ上の情報を自動的に収集し、検索エンジンやその他のサービスが利用できるようにデータベース化することが目的で、具体的には以下のような役割があります。

- 情報収集:

クローラーはインターネット上のウェブページを定期的に巡回し、テキスト、画像、リンクなどの情報を集めます。このプロセスは「クローリング」と呼ばれ、ウェブサイトのHTMLやその他のデータを解析します。 - インデックス作成:

収集した情報は、検索エンジンのデータベースにインデックスとして保存されます。これにより、ユーザーが検索した際に関連する情報を迅速に提供することが可能になります。 - SEOへの影響:

クローラーがウェブサイトを効率的に巡回するかどうかは、SEO(Search Engine Optimization)において重要です。クローラーに内容を正確に読み取ってもらうことで、検索結果でのサイトの可視性や順位が向上します。 - 更新の確認:

クローラーは既存のページの更新や新しいページの追加をチェックし、データベースを最新の状態に保つ役割も担います。これにより、検索結果が常に最新の情報を反映することができます。よって、ページ内容を更新していく事も重要となります。 - ウェブの健全性の維持:

クローラーはウェブサイトのリンクの有効性やエラーの存在をチェックすることで、ウェブ全体の健全性に貢献します。例えば、リンク切れやエラー404などが発生しているページを発見し、それを報告することでウェブサイトの管理者へのフィードバックとなります。

クローラーの活動は、検索エンジンの質を高めるだけでなく、ウェブのユーザーエクスペリエンス全体を向上させる重要な役割を果たしています。

3. クローリングの方法

クローリングの方法について、基本的なプロセスを以下に説明します。クローリングは主に以下のステップで行われます。

<シードURLの選定>

クローリングの開始点となるURL(シードURL)を選びます。これは通常、人気のあるサイトやディレクトリなどです。

<URLのキューイング>

シードURLをキューに追加します。このキューはクローラーが次に訪問するURLのリストです。

<ウェブページのダウンロード>

キューからURLを取り出し、そのページをダウンロードします。HTTPリクエストを送信し、レスポンスを解析します。

<HTMLの解析>

ダウンロードしたページのHTMLを解析し、テキスト、メタデータ、リンクなどを抽出します。

<新しいリンクの発見>

解析したページから新しいリンクを発見し、それらをキューに追加します。これによりクローリングがウェブ全体に拡大します。

<インデックス作成>

収集した情報を検索エンジンのデータベースにインデックスとして保存します。これにより検索クエリに対する後続の検索結果が可能になります。

<制限とポリシーの遵守>

クローリングには以下のような制限があります:

- robots.txt: サイトがクローラーに対してどの部分をクロールして良いか示すファイル。

- クロールレート: 一度にクロールする速度や頻度を制限するための配慮。

- HTTPヘッダ: “Disallow”や”Allow”などのディレクティブ。

<クローリングの深さと範囲の制御>

無限にリンクをたどることは現実的ではないため、深さや範囲を制御する戦略が必要です。例えば、特定の深さまでしかクロールしない、または特定のドメイン内に留めるなど。

<エラーハンドリング>

リンク切れ(404エラー)、サーバーエラー(500エラー)などのエラーに対応し、適切に処理します。

<更新の確認>

既存のページが更新されているかを定期的にチェックし、必要に応じて再クロールします。

3. robots.txtの尊重

robots.txtは、ウェブサイトのルートディレクトリに配置されるテキストファイルで、ウェブクローラー(特に検索エンジンのクローラー)に対してどのページをクロールすべきか、またはクロールすべきでないかを指示するために使用されます。このファイルは、サイトの運営者が自身のサイトのインデックス化を制御する重要な手段です。

robots.txtの基本的な構造は、ユーザーエージェント(クローラーの種類)とディレクティブで構成されます。

例えば、”User-agent: *”は全てのクローラーを対象に、”Disallow: /private/”はクローラーが/private/ディレクトリをクロールしないように指示します。また、”Allow: /public/”はクロールを許可するパスを指定します。

しかし、robots.txtは完全なブロック手段ではなく、悪意あるクローラーはこれを無視する可能性があります。また、重要な点として、robots.txtに記載されたページはクローラーにインデックス化されないよう指示しますが、既にインデックスされているページは削除されません。そのため、機密情報の保護には他の方法も併用する必要があります。

クローラーはサイトのrobots.txtファイルを尊重します。このファイルでは、クローラーがアクセスしてはいけないページやディレクトリを指定することができます。これにより、プライバシー保護やサーバーの負荷管理が可能になります。

4. クロールバジェット

クロールバジェットとは、Googleのクローラー(Googlebot)が一つのウェブサイトに対してどれだけのページをクロールするか、またはどれだけの時間をクロールに費やすかを指す概念です。クロールバジェットは、サイトのクロール頻度やクロールするページ数を制限するもので、大規模なサイトや頻繁に更新されるサイトにおいて特に重要になります。

このバジェットは、クローラーがサイトにアクセスできるリソース(時間やサーバーの負荷)の限界によって決まります。Googleはインターネット上に膨大な数のページがあるため、すべてのページを定期的にクロールすることは現実的ではありません。そのため、重要度の高いページを優先的にクロールし、低いページは頻度を減らします。

クロールバジェットを最適化する方法として、サイト構造の改善、robots.txtの適切な利用、不要なページの削除や404エラーの修正などがあります。これにより、検索エンジンが重要なコンテンツを効率的にインデックスできるようになり、SEO(検索エンジン最適化)のパフォーマンスが向上します。ただし、Google自体は「クロールバジェット」という用語を正式に使用していないこともあります。

5. まとめ

Googleクローラーは、検索エンジンの質を保つために不可欠な存在です。クローラーが効率的にサイトを巡回するためには、サイトの構造やrobots.txtの設定、クロールエラーの管理などが重要です。

これらの理解と適切な対応により、SEOの効果を最大化し、検索結果での可視性を高めることができます。

コメント